Con la rapida evoluzione della tecnologia di intelligenza artificiale (AI) in vari campi, in particolare l'AI generativa ** (Generative AI)L'aumento dei sistemi hardware per il calcolo ad alta velocità e capacità di elaborazione dati efficienti sta crescendo. In questo contesto,Connettore M.2Come tecnologia di interfaccia chiave, sta diventandoGli acceleratori AI e le unità a stato solido (SSD)** ad alte prestazioni svolgono un componente fondamentale.

Come marchio del connettore di TaiwanATTENDAgenti ufficiali autorizzati in Cina, ** BONCHIP (Www.bonchip.com.cn) ** si impegna a fornire ai clienti prodotti originali, il miglior prezzo e supporto tecnico professionale e ad aiutare i clienti a creare soluzioni di sistema embedded e AI orientate al futuro.

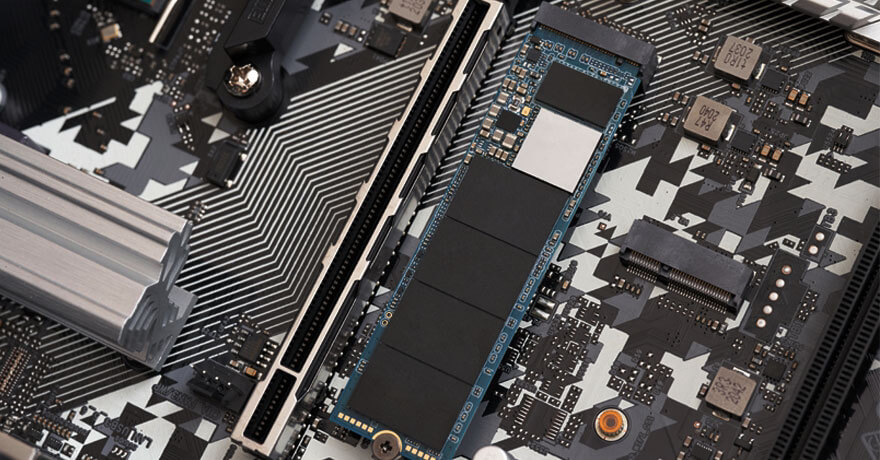

Il connettore M.2, originariamente chiamato Next Generation Interface Specification (NGFF), è progettato per ottimizzare le risorse PCIe (Peripheral Component Interconnect Bus Express). Non solo haVolume compattoELarghezza di banda ad alta velocitàVantaggi, anche supporti tra cuiPCIe, SATAABU' USBUna varietà di protocolli di segnale, tra cuiSistemi integrati, dispositivi AI, edge computing e storage ad alte prestazioniLa scelta ideale.

PCIe 3.0 / PCIe 4.0 / PCIe 5.0

Serial ATA(SATA 3.0)

USB 3.x SuperVelocità

Questa flessibilità del protocollo consente al connettore M.2 di essere ampiamente utilizzato nelle piattaforme embedded.Scheda acceleratore AI, scheda di acquisizione video, modulo 5G/4G, modulo di comunicazione IoT wireless e scheda di espansione per l'automazione industriale。

Protocollo SATA AHCICompatibile con i tradizionali HDD/SSD per soluzioni di storage a basso costo

Canale PCIe Protocollo NVMeOttimizzato per SSD, fornendo prestazioni di lettura e scrittura estreme, particolarmente adatte per la formazione del modello AI e le attività di inferenza

Agent-BONCHIP ATTEND Il connettore PCIe M.2 Gen5, che supporta completamente i segnali e i protocolli di cui sopra, è ampiamente utilizzato.Terminale AIoT, strumento medico intelligente, scheda di controllo industriale e server edgeAspetta.

Gli acceleratori AI (come GPU, TPU, FPGA, ASIC, ecc.) Sono processori ottimizzati per l'apprendimento profondo e il calcolo di rete neurale. Questi moduli hanno requisiti estremamente elevati per larghezza di banda, throughput di dati e bassa latenza.

PCIe multicanale ad alta larghezza di banda: Garantire un flusso di dati rapido per l'addestramento del modello su larga scala e l'inferenza dei dati.

Piccolo design per una facile integrazione: Adatto per laptop, box AI incorporato, attrezzature per veicoli e altri spazi con piattaforma limitata

Forte compatibilità del protocollo: Supporta vari moduli di accelerazione AI per adattarsi alle diverse esigenze della scena

Espansione modulareSupporta hot plug ed espansione flessibile, facile aggiornamento del sistema e distribuzione personalizzata

Nel sistema AISSDÈ necessario intraprendere il compito di archiviazione ad alta velocità e richiamo di dati di formazione su larga scala, in particolare inApplicazioni AI generative in tempo realeIl sistema ha requisiti elevati per la latenza di archiviazione, la larghezza di banda e le capacità di elaborazione simultanea.

Aumento significativo della larghezza di banda di lettura e scritturaNVMe SSD con interfaccia M.2, velocità di lettura e scrittura fino a diversi GB/s

Latenza di accesso ultra-bassa: Particolarmente critico per gli scenari di inferenza AI in tempo reale (ad esempio riconoscimento dell'immagine, elaborazione vocale)

Capacità avanzate di edge computing: Alcuni SSD M.2 integrano coprocessori AI per abilitare la preelaborazione dei dati locali e ridurre la pressione sul sistema principale.

I modelli AI generativi, rappresentati da GAN e Transformer, richiedono molta potenza di calcolo e enormi risorse di archiviazione, e l'applicazione di connettori M.2 consente l'integrazione flessibile di queste risorse, guidando il rapido atterraggio dell'IA generativa in più settori.

Miglioramento dell'efficienza della formazione: Scheda di accelerazione AI NVMe SSD lavorare insieme per abbreviare in modo significativo il ciclo di allenamento del modello.

Diminuzione della latenza dell'inferenza: Risposta più fluida per scene in tempo reale come la generazione di immagini e la creazione di contenuti

La scalabilità del sistema è più forte: Supporta il multi-modulo a cascata per adattarsi alla crescente tendenza delle dimensioni del modello

Promuovere l'innovazione nella ricerca sull'IAI colli di bottiglia dell'hardware ridotti consentono ai ricercatori di concentrarsi sull'ottimizzazione degli algoritmi e sull'espansione del modello.

La tecnologia M.2 è ancora in rapida evoluzione e si prevede che in futuro guiderà ulteriormente l'hardware AI:

✅ Più trasmissione ad alta velocità: SupportoSpecificazione di PCIe 5.0/6.0, La velocità di trasmissione è aumentata a 64GT/s o addirittura superiore

✅ Dimensioni più piccole, minor consumo energetico: Adattarsi ai dispositivi edge e ai dispositivi portatili

✅ Maggiore sicurezza e stabilitàCrittografia hardware integrata, protezione spegnente, controllo dell'integrità dei dati e altre funzioni

✅ Integrazione della funzione più intelligente: Accelerazione AI, interfaccia I/O programmabile, co-elaborazione della rete neurale incorporata, ecc.

Come agente principale di ATTEND in Cina, BONCHIP fornisce ai clienti servizi daApplicazione del campione, guida alla selezione del tipo, supporto tecnico all'acquisto di massaServizio one-stop, una vasta gamma di servizi.Istituti di ricerca e sviluppo di intelligenza artificiale, produttori di dispositivi embedded, integratori di sistemi e piattaforme di ricerca universitarie。

✅ La garanzia originale del rifornimento diretto della fabbrica, uno falso compensa dieci

✅ Inventario flessibile, fornitura veloce

✅ Supporto tecnico speciale, selezione del tipo senza preoccupazioni

✅ Il prezzo è competitivo nel mercato

✅ Supporta i requisiti di corrispondenza e personalizzazione del progetto

📞Accesso immediato:Www.bonchip.com.cn per il supporto tecnico o soluzioni di connettori M.2!